Die Welt steht vor einem fundamentalen Umbruch ihrer gesamten Energieversorgung. Dabei stehen alle derzeit bekannten Verfahren auf dem Prüfstand. Eine Technologie, die in den sechziger und siebziger Jahren unbeschränkte Verfügbarkeit versprach, nämlich die Atomenergie, ist aus einer Reihe von Gründen in Verruf geraten und wird heute nur in wenigen Ländern in Betracht gezogen. Wasserkraft wiederum ist aus anderen Gründen nur beschränkt ausbaubar. Unter anderem wegen der immensen Auswirkungen auf die Landschaft und den damit verbundenen Konsequenzen für Flora und Fauna. Biomasse wiederum steht in Konkurrenz zur Lebensmittelerzeugung und stößt ebenfalls auf ihre Grenzen.

Bisher waren also die fossilen Energieträger Öl, Gas und Kohle das Mittel zur Wahl. Im Gegensatz zu früheren Prognosen sind sie weiterhin fast unbegrenzt verfügbar, preiswert und vielseitig einsetzbar. Es ging nicht nur um Energieerzeugung, sondern auch um Grundstoffe für die Chemie, die Pharmazie und viele andere Bereiche.

Für die Bereitstellung elektrischer Energie sind nun in den vergangenen 20 Jahren immer stärker zwei Vertreter der sogenannten „Erneuerbaren Energien“ hervorgetreten. Abgesehen von der Tatsache, dass Energie nicht „erneuerbar“ ist, denkt jeder hier zunächst an Wind und Sonne, also an Energieträger, die scheinbar kostenlos zur Verfügung stehen. Tatsächlich haben hier in dem besagten Zeitraum erstaunliche Entwicklungen stattgefunden, einerseits bezüglich der Größenordnung und anderseits bezüglich der Kosten.

Dass heute Windkraftanlagen von bis zu 18 MW pro Einheit auf See installiert werden, war noch in den achtziger Jahren unvorstellbar. Dass wiederum Photovoltaikanlagen in sonnenreichen Gebieten Strom zu Kosten von unter 1 Cent pro kWh erzeugen würden, war bestenfalls Utopie.

Ausgleich zwischen Angebot und Nachfrage

Sind damit nun alle Probleme gelöst? Keineswegs, denn es stellen sich fundamentale Probleme, die leider über einen langen Zeitraum fahrlässig unterschätz wurden. Deutschland ist eines der Länder auf der Welt, die über eine jederzeit zuverlässige Versorgung mit elektrischer Energie verfügen. Das ist alles andere als eine Selbstverständlichkeit, selbst in hochentwickelten Staaten. Dabei ging es bei der Auslegung des Versorgungssystems immer darum, den absoluten Höchstbedarf in jedem Fall abdecken zu können, auch wenn er nur für 1 Stunde im Jahr anfallen sollte. Die Erzeugung richtet sich also nach dem Bedarf, nicht nur zeitlich, sondern auch räumlich. Deswegen war es auch sinnvoll, große Kraftwerke in der Nähe großer Verbraucher zu bauen. Wobei dies bevölkerungsreiche Metropolen oder auch Standorte der Schwerindustrie zum Beispiel sein konnten.

Mit den beiden Energiequellen Sonne und Wind sind diese Voraussetzungen nicht mehr gegeben. Die Positionierung von Windkraftanlagen hängt von verfügbaren Flächen und auch dem „Windangebot“ ab. Die Installation von PV-Modulen hängt wiederum stark von der individuellen Investitionsbereitschaft von Privatpersonen ab. Die Lieferung von Energie dieser Anlagen ist wiederum von Witterungsbedingungen abhängig.

Deutschland hat sich den Luxus von zwei Energieversorgungen über Jahre geleistet, um die beschriebenen Probleme zu kompensieren. Auch wenn heute verkündet wird, dass wir 46% des Stroms regenerativ erzeugen, so sind es doch an bestimmten Tagen im Jahr kaum mehr als 20%. Je weiter wir die konventionellen Kraftwerke reduzieren, je mehr laufen wir in eine nicht mehr beherrschbare Situation.

Das Verhältnis zwischen Angebot und Nachfrage muss also ausgeglichen werden und dies nicht nur kurzeitig, sondern auch saisonal. Denn es ist trivial zu erkennen, dass im Winter mehr Energie benötigt wird als im Sommer. Es bedarf also eines Mediums, das Energie über beliebige Zeiträume speichern kann, leicht transportierbar ist und sich vielseitig einsetzen lässt, unter anderem auch zur Rückverstromung.

Wenn wir Deutschland als Referenz betrachten, so wird der gesamte Energiebedarf des Landes aber nur zu ungefähr 20% durch Elektrizität gedeckt, der weitaus größere Teil also im Wesentlichen durch Öl, Gas und Kohle versorgt. Dazu gehört der gesamte Verkehrsbereich, der Wärmemarkt, aber auch die Industrie, insbesondere im Bereich Stahl, Chemie, Zement, Glas und andere. Nun kann man trefflich darüber philosophieren, wie viel sich davon „elektrifizieren“ lässt, aber das wird letztendlich die Zukunft zeigen und es wird definitiv von Kosten und Verfügbarkeit abhängen.

Speichermedium Wasserstoff

Die Trumpfkarte in dem Spiel heißt Wasserstoff. Darüber besteht heute weltweit Einigkeit. Als Speichermedium kann er die erratisch schwankenden Leistungen aus Wind- und Sonnenenergie ausgleichen und als Grundstoff mit seinen bekannten Derivaten die fossilen Stoffe in allen Anwendungen ersetzen. Wie das in der Praxis genau zu bewerkstelligen ist, würde den Rahmen dieses Artikels sprengen. Unbestrittene Tatsache ist aber inzwischen, dass gigantische Mengen des sogenannten „grünen“ Wasserstoffs benötigt werden. Letzterer wird durch elektrolytische Spaltung mittels elektrischen Stroms aus Wasser erzeugt. Es erfolgt eine Aufspaltung von Wasser in Wasserstoff und Sauerstoff. Dieser Vorgang erfolgt in einem Elektrolyseur. Die Umkehrung des Prozesses findet in der Brennstoffzelle statt. Dort dient er als Treibstoff und in Verbindung mit dem Sauerstoff wird dann Strom erzeugt. Das „Abfallprodukt“ ist Wasser.

Der Rohstoff Wasser ist auf unserem Planeten de facto unbegrenzt verfügbar in Form der Meere. Strom muss allerdings erzeugt werden. Gelingt dies klimaneutral, dann kann der Umbau unserer Energieversorgung derart erfolgen, dass die Bilanz von CO2 Erzeugung und Absorption wieder ins Gleichgewicht gebracht und die weitere Erwärmung der Atmosphäre gestoppt werden kann.

Der Einsatz von Wasserstoff und seinen Derivaten wird in naher Zukunft also von der Verfügbarkeit und dem Preis abhängen. Bei der Herstellung spielt zum einen der Strompreis eine wesentliche Rolle und zum anderen die Anschaffungskosten der Anlagen. Obwohl technologisch sehr ähnlich, spielen Elektrolyseure und Brennstoffzellen in verschiedenen Ligen. Elektrolyseure haben bei der Erzeugung von grünem Wasserstoff ein Alleinstellungsmerkmal, während Brennstoffzellen im Wettbewerb zu anderen Verfahren stehen. Im Schwerlastverkehr etwa konkurrieren Wasserstoffantriebe mit batterie-getriebenen Elektromotoren.

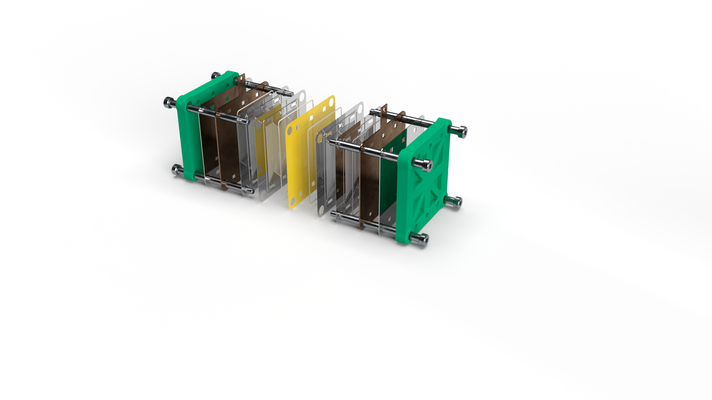

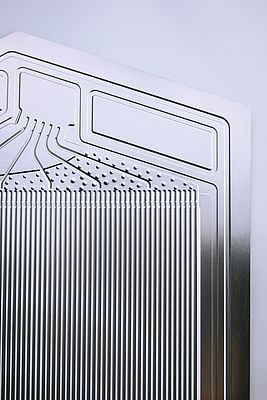

Nichtsdestotrotz geht es in beiden Fällen um die signifikante Steigerung der Produktionsstückzahlen, um einerseits den massiv wachenden Bedarf zu decken und anderseits die Kosten nachhaltig zu reduzieren. Es geht also um die Industrialisierung, sprich Automatisierung der Fertigung. Kernkomponenten sind dabei die Bipolarplatten (BPP) und die Membran-Elektroden-Einheit (MEA). Bei Letzterer unterscheidet man 3-, 5-, und 7-Lagen MEAs. Dazu werden katalytische Schichten aufgebracht, die für die elektrolytischen Prozesse notwendig sind.

Beim Fraunhofer-Institut für Werkzeugmaschinen und Umformtechnik IWU in Chemnitz wird derzeit das Projekt „Referenzfabrik H2“ gestartet, bei dem es um die Optimierung der Fertigung dieser Komponenten geht. Angefangen von der Herstellung der Bipolarplatten, über die Funktion von Dichtungen bis zum Zusammenbau des kompletten Stack, sollen hier Verfahren untersucht, erprobt und optimiert werden.

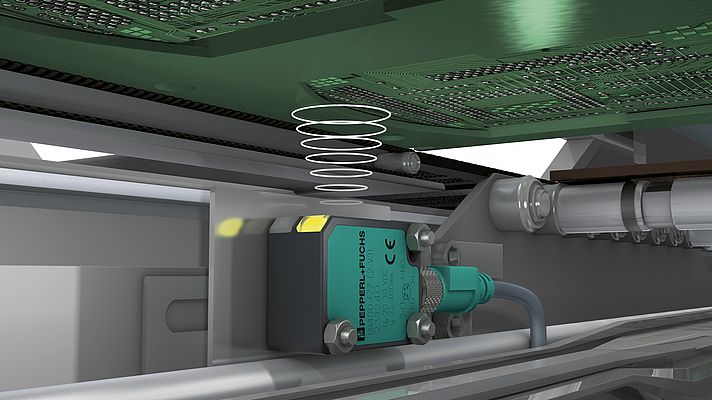

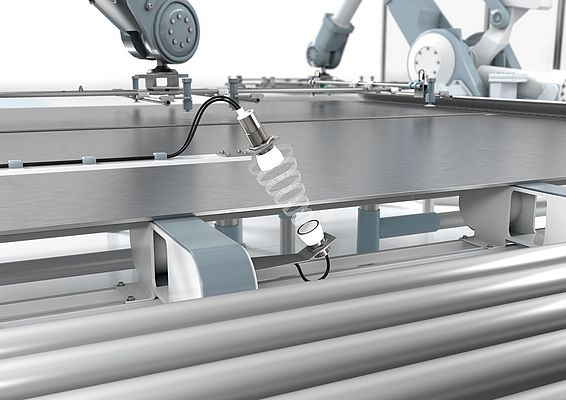

In ersten praktischen Anwendungen hat sich gezeigt, dass die Überprüfung von möglichen Doppellagen ein Kriterium sein kann. Dabei hat sich die Ultraschall-Sensorik als probate Sensortechnologie bewährt. Grundsätzlich können solche Sensoren Distanzen im zehntel Millimeter Bereich genau messen, Mehrfachlagen oder auch Risse erkennen. Der Vorteil von Ultraschall besteht insbesondere darin, dass er unabhängig von der Materialbeschaffenheit des Objekt, also der Farbe, des Oberflächenglanzes oder der Transparenz arbeitet. Dies bietet große Vorteile gerade bei metallischen aber auch bei lichtdurchlässigen Materialien.

Mit Sensoren der Baureihe F77 von Pepperl+Fuchs können Höhenmessungen im Bereich von 0,2 mm genau durchgeführt werden. Doppelbogenkontrollen vom Typ UDC können Mehrfachlagen erkennen, da sie Grenzschichten, also den Übergang zu einem Luftspalt, detektieren. Nicht zuletzt können die zugeführten Komponenten schlicht auf Anwesenheit oder ihre Lage überprüft werden. Diese modernen Sensoren besitzen eine standardisierte IO-Link Schnittstelle, über die Einstellung vorgenommen, aber auch Zustandsdaten abgefragt werden können. Die ebenfalls verfügbaren Interface-Module (Master) transferieren die Daten via OPC UA zu anderen Einheiten der IT-Infrastruktur. Damit sind alle Voraussetzungen einer Architektur im Sinne von Industrie 4.0 gegeben.

Autor: Wolfgang Weber, Pepperl+Fuchs