Der Traum, dass eine Maschine intelligente Entscheidungen trifft, existiert schon länger, als es Computer gibt. Erste Ansätze stammen aus den 1950er-Jahren. Einen wahren Boom erlebt KI jedoch erst seit einigen Jahren. Der jüngste Hype geht mit dem Launch von ChatGPT und ähnlichen Angeboten einher. Doch der Weg, Künstliche Intelligenz als Standardprodukt in der Smart Factory zu nutzen, scheint immer noch weit zu sein.

Der lange Weg zur KI-Lösung

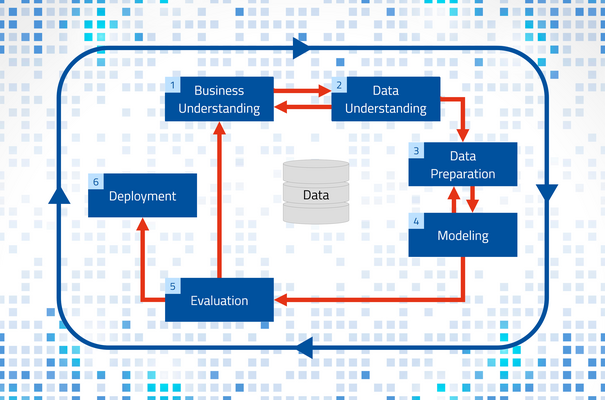

Warum kann man Künstliche Intelligenz nicht einfach zuschalten wie den LED-Blitz am Handy, der zumindest im näheren Umfeld eine bessere Belichtung verspricht? Ein Blick hinter die Kulissen sorgt für Klarheit: Im Jahr 1996 wurde ein branchenübergreifendes Standardvorgehen für den Umgang mit großen Datenmengen entwickelt, das auch heute noch in KI-Projekten genutzt wird: Cross Industry Standard for Data Mining (CRISP-DM). Darin ist anwendungsneutral beschrieben, was getan werden muss, bevor man aus großen Datenmengen einen Nutzen ziehen kann. Hierbei sind sechs Phasen zu durchlaufen:

- Geschäftsverständnis (Business Understanding)

- Datenverständnis (Data Understanding)

- Datenvorbereitung (Data Preparation)

- Modellierung (Modeling)

- Evaluierung (Evaluation)

- Bereitstellung (Deployment)

Insbesondere auf die Phasen vor der Modellierung entfällt in KI-Projekten ein Großteil der Zeit und der Kosten. Diesen Aufwand muss ein Data Scientist für jedes Projekt von Neuem betreiben. Ist ein KI-Modell fertig, kann es ausgerollt und solange genutzt werden, bis sich die Rahmenbedingungen geändert haben und das Modell überarbeitet werden muss. Ideal und kostensparend wäre es, sowohl das Erstellen als auch das Erweitern von KI-Modellen zu automatisieren – quasi Automated Data Science. Man kann die Daten aber auch so zur Verfügung stellen, dass die ersten drei Phasen überflüssig werden und sofort mit dem Modellieren begonnen werden kann.

KI als Standardlösung

Daten in einer homogenen Form bereitzuhalten, gehört zu den Kernaufgaben moderner Fertigungs-IT. Die Schlagworte lauten Integrationsplattform und semantisches Datenmodell. Sind alle Daten in einer gemeinsamen Plattform semantisch abgelegt, so ist es für KI-Software ein Leichtes, darauf zuzugreifen und die Daten zur Modellbildung zu verwenden. Die Manufacturing Integration Platform (MIP) von MPDV ist eine solche Integrationsplattform, die als gemeinsame Datenbasis genutzt werden kann. Sie hält umfangreiche Daten vor, die von unterschiedlichen Anwendungen genutzt und verarbeitet werden. Ob man die Nutzgrade einer Maschine analysiert oder vorhersagt, wie lange die Rüstzeit bei einem bestimmten Artikelwechsel sein wird, ist für die Plattform vorerst irrelevant. Die semantische Ablage der Daten stellt sicher, dass jede Anwendung die Daten versteht und für den jeweiligen Zweck nutzen kann. Damit ist der Weg frei für Standardanwendungen.

Seitens der KI-Engine ist das Prinzip immer gleich:

- Die Software analysiert historische Daten.

- Die KI erkennt Muster und ermittelt Einflussfaktoren.

- Anhand dieser Erkenntnisse visualisiert die KI Zusammenhänge. Alternativ kann die KI auf Basis der Erkenntnisse Vorhersagen treffen.

KI in der Smart Factory

Die Feinplanung von Aufträgen, Werkzeugen und Mitarbeitenden ist nur ein Beispiel, in dem KI in der Smart Factory für mehr Effizienz und Wettbewerbsfähigkeit sorgt. Dank KI-Unterstützung werden Produktionskosten gesenkt, die Termintreue gesteigert und die vorhandenen Ressourcen optimal eingesetzt. Wenn alle benötigten Daten dafür strukturiert und semantisch geordnet vorliegen, kann eine solche Planungsanwendung Szenarien aller Art planen.

Gleiches gilt für die KI-basierte Analyse von Ausschuss oder Nutzgraden. Der KI-Algorithmus analysiert die historischen Daten, erkennt Einflussfaktoren und stellt diese in einer Form dar, aus der der Benutzer mit seinem Domänenwissen zielführende Schlüsse ziehen kann. Solange alle Daten nach dem gleichen Prinzip aufgebaut sind, kann die KI damit arbeiten. Sie liefert Ergebnisse, die anschließend mit der gleichen „Brille“ betrachtet werden können wie die Eingangsdaten.

Praxisbeispiel: Predictive Quality

Predictive Quality basiert auf der Erfahrung, dass auch dann Ausschuss oder Nacharbeit auftreten können, wenn sich alle Prozessparameter innerhalb der Toleranzgrenzen bewegen. Grund dafür sind komplexe Zusammenhänge und Wechselwirkungen, die auf die eigentliche Fertigungstechnologie zurückgehen. In der Praxis werden verschiedene Prozesswerte zusammen mit der Qualitätseinstufung als Basis dafür verwendet, zu entscheiden, mit welcher Wahrscheinlichkeit das Produkt ein Gutteil wird oder Ausschuss. Dafür ist eine repräsentative Sammlung von Daten nötig. Genauer gesagt ein möglichst breites Feld an Prozessdaten, die sich mit dazu passenden Qualitätsdaten korrelieren lassen. Wichtig ist dabei, dass Prozesswerte und Qualitätseinstufungen synchron sind. Neben der reinen Masse an Daten ist die Vielfältigkeit dafür entscheidend, wie zuverlässig die späteren Vorhersagen sind. Einfacher gesagt: Je mehr sich die Prozesswerte innerhalb ihrer zulässigen Toleranzen verändern und je mehr Kombinationen unterschiedlicher Extremwerte erfasst werden, desto besser.

Aus der Gesamtheit dieser Daten entwickelt die Künstliche Intelligenz ein Vorhersagemodell, das mit den aktuellen Prozessdaten gefüttert werden kann. Das Ergebnis ist sowohl eine Qualitätseinstufung als auch eine Wahrscheinlichkeit dafür, dass diese Einstufung richtig ist. Anschließend liegt es in der Verantwortung des Menschen, zu entscheiden, was mit den Ergebnissen passiert. Man könnte zum Beispiel alle Teile, die mit mehr als 60 % Wahrscheinlichkeit Ausschuss sind, sofort recyceln oder explizit prüfen. Teile, die zu mehr als 90 % die Einstufung Gutteil bekommen, werden ungeprüft ausgeliefert. Je nach Branche und Wertigkeit der Artikel könnten die Ergebnisse aus Predictive Quality aber auch ganz anders verwendet werden. Diese Entscheidung kann uns die KI nicht abnehmen – wohl aber die Analyse der Daten und die Vorhersage der Ergebnisse.

Was tun?

Es bleibt die Frage zu klären, ob man KI in der Smart Factory einsetzen sollte und wenn ja, wofür. Diese Frage muss jedes Fertigungsunternehmen selbst eruieren. Einen Denkanstoß könnte die AI Suite von MPDV liefern. Zur AI Suite gehören acht Standardanwendungen, die jede für sich gesehen einen Mehrwert bietet und für mehr Wettbewerbsfähigkeit sorgt. AI Planning zielt zum Beispiel darauf ab, die Produktionskosten zu senken und die Termintreue durch eine optimale Planung zu steigern. Andere Anwendungen unterstützen dabei, schwankende Nutzgrade einzelner Maschinen zu erklären, ermitteln Einflussfaktoren auf den Rüstgrad einzelner Maschinen oder sagen die Qualität von Produkten vorher. Dafür nutzen sie Daten aus der Manufacturing Integration Platform (MIP) und können daher ohne großen Zusatzaufwand eingesetzt werden – so einfach wie der LED-Blitz am Handy

Autor: Markus Diesner, Principal Marketing MPDV